이번 주에 Level2 실전 프로젝트 1이 시작됨에 따라

일정 관리가 정말로 빡세졌다.

팀적으로 맞춰야할 부분도 있고

최종 프로젝트 논의도 해야 하고

강의도 또 다들어야 하고

당장의 프로젝트도 해야 하며

또 그간 진행해왔던 스터디도 이어가야 한다.

스터디 과제도 차차 해나가야지.

할 게 많은데 어느 하나 놓칠 수 없는 것들이다.

오늘은 일단 첫 번째 프로젝트 회고를 끝냈고

또 일지 작성 후에 삶의 지도도 간단하게 써서 머릿속에서 치워버릴 생각이다.

오늘은 일단 7강 까지의 강의를 수강 완료하였다.

영어 쉐도잉과 모닝 코딩의 일과도 무사히 수행하였다.

우리 팀을 소개합니다 피피티도 완료하였고 팀적인 논의도 조금 진행하였다.

눈에 띄지 않을 지라도 발전이 각 부분에서 조금씩은 있었던 하루였다.

강의 듣고서는 선형대수 스터디에 참여하였다.

학습한 내용을 다시 복기하였고 문제 풀이도 진행하였다.

조금 욕심이 나서 주말에 정리하거나 미처 못본 부분들 다 볼 생각이다.

오늘의 학습 내용을 정리하며 짧게 마치겠다.

GLUE datasets

MNLI : 두 문장의 관계 분류를 위한 데이터셋

QQP : 두 질문이 의미상 같은지 다른지 분류를 위한 데이터셋

QNLI : 질의응답 데이터셋

SSTS-2 : 영화 리뷰 문장에 관한 감성 분석을 위한 데이터셋

CoLA : 문법적으로 맞는 문장인지 틀린 문장인지 분류를 위한 데이터셋

STS-B : 뉴스 헤드라인과 사람이 만든 paraphrasing 문장이 의미상 같은 문장인지 비교를 위한 데이터셋

MRPC : 뉴스의 내용과 사람이 만든 문장이 의미상 같은 문장인지 비교를 위한 데이터셋

RTE : MNLI와 유사하나 상대적으로 훨씬 적은 학습 데이터셋

WNLI : 문장 분류 데이터셋

SQuAD v1.1 : 질의 응답 데이터셋

CoNLL 2003 : 개체명 분류 데이터셋

SWAG : 현재 문장 다음에 이어질 자연스러운 문장을 선택하기 위한 데이터셋

형태소 단위로 분리 후 분리된 것을 바탕으로 tokenizer에 넣는 방법 소개

주요 Entity를 추출한 후 Entity tag 부착,

Entity Embedding layer 추가

형태소 분석을 통해 NNP와 entity 우선 chunking, masking

vocab size : 3만개 정도 만들면 될듯

add_special_tokens : dictionary로 전달

special token을 만들고 나면 tokenizing에 이점이 있음

added_token_num을 저장해두고 후에 모델에 반영

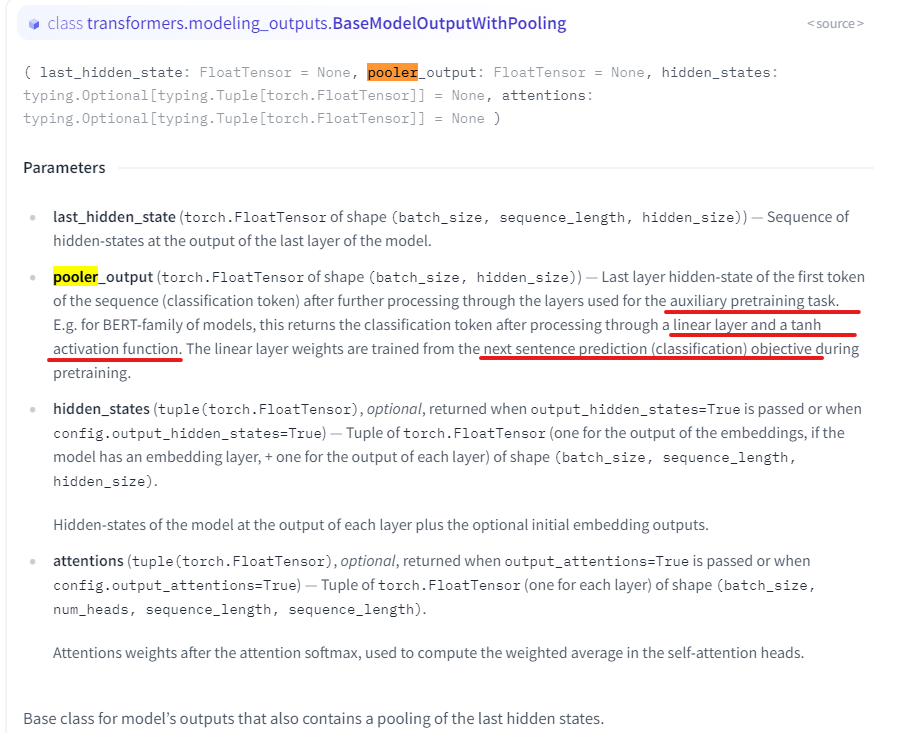

outputs.last_hidden_state : 각 토큰들에 대한 model last layer의 hidden-state vector

outputs.pooler_output :

sequence 첫 번째 토큰 (classifcation token)의 auxiliary pretraining task layer를 통과한 last layer hidden-state vector

BERT-family of models, linear layer + tanh activation function을 통과

linear layer의 weights는 pretraining 과정에서 Next Sentence Prediction objective로 훈련됨

BERT 모델 학습

BERT 학습의 단계

1. Tokenizer 만들기

2. 데이터셋 확보

3. Next sentence prediction (NSP)

4. Masking

왜 새로 학습해요?

도메인 특화 task의 경우, 도메인 특화된 학습 데이터 만 사용하는 것이 성능이 더 좋다!

readline() 후에 무조건 strip()해줘야 한다.

의존소 지배소

- 지배소 의미의 중심이 되는 요소

- 의존소 지배소가 갖는 의미를 보완해주는 요소 (수식)

model.num_parameters()

model.parameters

음절 단위 태깅을 적극적으로 권장

'느린 일지 > 부스트캠프 AI Tech 4기' 카테고리의 다른 글

| [학습 일지 / day 41] 기대면 안되! (4) | 2022.11.18 |

|---|---|

| [학습 일지 / day 40] 발표와 휴식 (4) | 2022.11.17 |

| [학습 일지 / day 38] 삶의 균형 (0) | 2022.11.16 |

| [학습 일지 / day 37] 피로 (4) | 2022.11.12 |

| [학습 일지 / day 36] 삽질 (6) | 2022.11.10 |